Souhrn

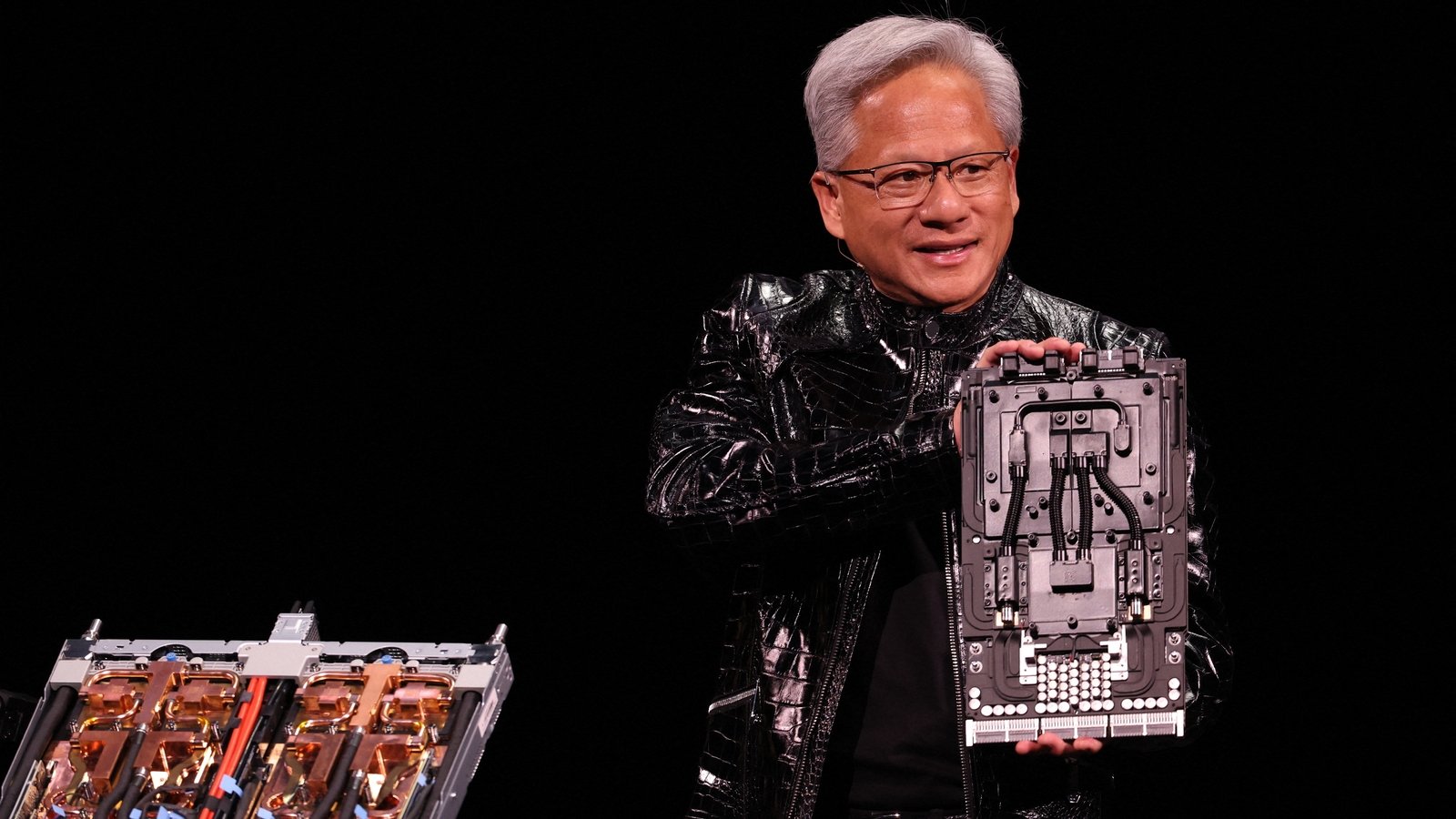

Generální ředitel Nvidia Jensen Huang na veletrhu Consumer Electronics Show (CES) 2026 v Las Vegas prohlásil, že nová generace čipů společnosti je v plné produkci. Tyto čipy nabízejí pětkrát vyšší výpočetní výkon pro AI úlohy oproti předchozím modelům, zejména při zpracování chatbotů a dalších AI aplikací. Platforma Vera Rubin, která debutuje letos později, je již testována AI firmami v laboratořích Nvidia.

Klíčové body

- Čipy Vera Rubin jsou v plné produkci a poskytují 5násobný AI výkon oproti předchozí generaci.

- Platforma zahrnuje šest samostatných čipů; vlajkový server obsahuje 72 grafických procesorů (GPU) a 36 centrálních procesorů (CPU).

- Možnost propojení do „podů“ s více než 1000 čipy Vera Rubin pro 10násobnou lepší efektivitu generování tokenů, což jsou základní jednotky AI systémů reprezentující slova nebo jejich části.

- Nová vrstva úložiště „context memory storage“ určená k urychlení odpovědí chatbotů na delší dotazy.

- Výkon dosažen díky proprietárním datům, které Nvidia doufá, že se stane standardem v oboru.

Podrobnosti

Jensen Huang, zakladatel a generální ředitel Nvidia – společnosti, která je současně nejcennější firmou na světě díky dominanci v AI hardwaru – představil na CES 2026 podrobnosti o platformě Vera Rubin. Tato platforma sestává ze šesti oddělených čipů a je navržena pro nasazení v serverech s 72 GPU a 36 CPU. Tyto servery lze propojovat do velkých shluků nazývaných „pody“ s přes 1000 čipy Vera Rubin, což umožňuje výrazně vyšší efektivitu při generování tokenů. Tokeny představují atomární jednotky v AI modelech, jako jsou velké jazykové modely (LLM), kde každý token odpovídá části slova nebo celému slovu; jejich rychlé zpracování je klíčové pro plynulost chatbotů, jako jsou ChatGPT nebo Gemini.

K dosažení 5násobného výkonu oproti předchozí generaci (pravděpodobně Blackwell) a 10násobné úspory při tokenizaci Huang zmínil použití proprietárního formátu dat, který má vyšší hustotu informací. To umožnilo zlepšení výkonu při pouze 1,6násobném počtu tranzistorů. Nvidia již testuje tyto čipy v laboratořích s AI firmami, přestože masové nasazení přijde až později letos. Dále představila „context memory storage“, novou vrstvu úložiště, která ukládá kontext delších konverzací a umožňuje chatbotům rychleji načítat a zpracovávat dlouhé dotazy bez ztráty výkonu.

Nvidia čelí rostoucí konkurenci: tradiční rivalové jako Advanced Micro Devices (AMD) zlepšují své GPU pro AI, zatímco zákazníci jako Google (Alphabet) vyvíjejí vlastní čipy (např. TPU). Přesto Nvidia drží převahu v tréninku AI modelů, ale v inference – tedy nasazení hotových modelů pro miliony uživatelů – se soutěž zesiluje.

Proč je to důležité

Tato novinka posiluje pozici Nvidia v AI ekosystému, kde inference tvoří většinu budoucího tržního růstu, protože trénink modelů se stabilizuje. Pětkrát vyšší výkon znamená nižší náklady na provoz AI služeb, rychlejší odpovědi a škálovatelnost pro aplikace jako chatboti, generování obrázků nebo autonomní systémy. Pro průmysl to znamená, že firmy jako OpenAI nebo Meta budou moci efektivněji obsluhovat stovky milionů uživatelů, což urychlí adopci AI. Kriticky však závisí na širokém přijetí Nvidia proprietárních dat; pokud se nestane standardem, výhoda se zmírní. V kontextu konkurence to núká AMD a Google k inovacím, což nakonec prospěje celému sektoru nižšími cenami hardware.

Zdroj: 📰 RTE