Souhrn

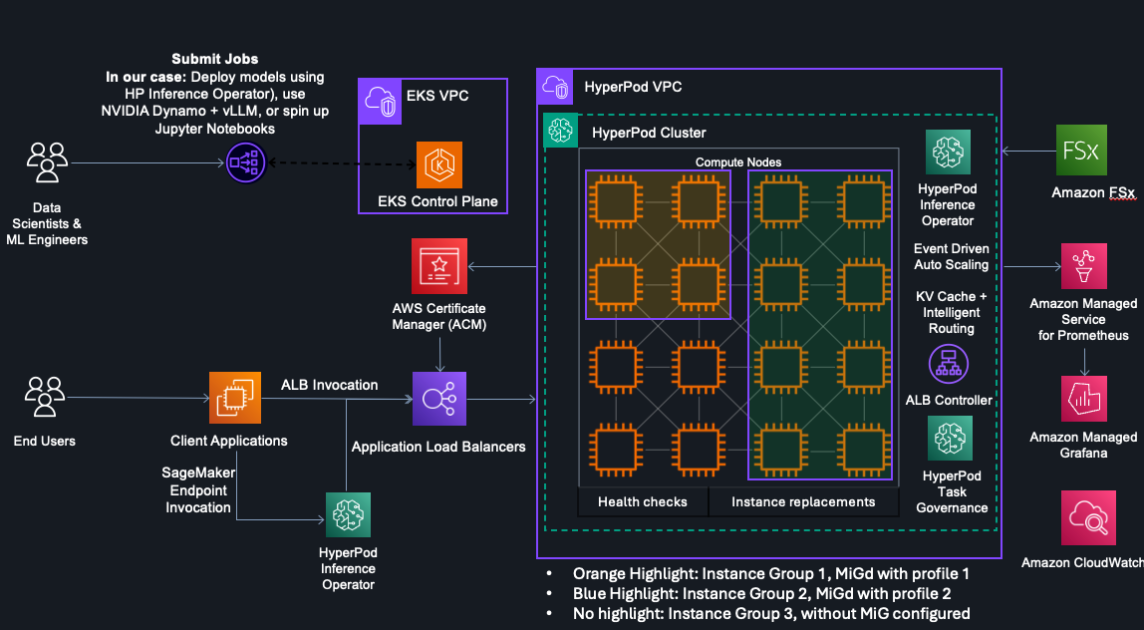

Amazon SageMaker HyperPod nyní plně podporuje technologii NVIDIA Multi-Instance GPU (MIG), díky čemuž lze jednotlivá GPU rozdělit na více izolovaných instancí. Tato funkce zvyšuje využití výpočetních a paměťových prostředků při běhu lehkých AI úloh, jako je inference jazykových modelů, prototypování modelů nebo práce v Jupyter notebooku.

Klíčové body

- HyperPod nyní umožňuje paralelní běh více úloh na jednom fyzickém GPU pomocí MIG.

- Podpora zahrnuje GPU založené na architektuře NVIDIA Ampere, například A100 (EC2 P4) a A10G (EC2 G5).

- Izolace mezi instancemi zajišťuje bezpečnost a stabilitu výkonu jednotlivých úloh.

- Administrátoři clusterů mohou efektivněji alokovat zdroje mezi různé týmy (datoví vědci, ML inženýři, infrastruktura).

- Snížení čekacích dob na GPU a zkrácení vývojových cyklů.

Podrobnosti

NVIDIA Multi-Instance GPU (MIG) byla představena v roce 2020 spolu s architekturou Ampere. Umožňuje rozdělit jedno GPU (např. A100) na až sedm nezávislých instancí, z nichž každá má vlastní paměť, cache a výpočetní jednotky. Amazon nyní tuto technologii integroval do SageMaker HyperPod – spravované platformy pro škálovatelný vývoj a nasazení AI modelů. Díky tomu mohou uživatelé spouštět lehké úlohy, které by jinak nevyužívaly plný výkon celého GPU, na menších izolovaných částech. Například inference jazykového modelu nebo experimenty s klasifikací obrazu v Jupyter notebooku mohou běžet paralelně na stejném hardwaru bez vzájemného ovlivnění. Platforma zároveň poskytuje přehled o využití výpočetních a paměťových zdrojů na úrovni jednotlivých MIG instancí.

Proč je to důležité

Tato funkce přináší významné zlepšení efektivity výpočetních clusterů, zejména v prostředích, kde běží směs lehkých a náročných úloh. Pro organizace, které provozují vlastní AI infrastrukturu v cloudu, to znamená nižší náklady a lepší využití investic do drahých GPU. Zároveň podporuje agilnější vývoj – datoví vědci nemusí čekat na uvolnění celého GPU, ale mohou okamžitě využít dostupnou MIG instanci. V kontextu rostoucí poptávky po generativní AI jde o pragmatický krok k optimalizaci existujících zdrojů, nikoli o zásadní průlom, ale jistě o užitečné vylepšení pro praxi.

Zdroj: 📰 Amazon.com

|

|  | flashlights, headlamps Fenix & outdoor | Vybavení do přírody | Brandýs nad Labem-Stará Boleslav | Letní škola AI

| flashlights, headlamps Fenix & outdoor | Vybavení do přírody | Brandýs nad Labem-Stará Boleslav | Letní škola AI