Souhrn

Nový dataset Fair Human-Centric Image Benchmark (FHIBE) nabízí systematicky navrženou, veřejně dostupnou sadu snímků lidí, která respektuje souhlas, soukromí, férovou kompenzaci a bezpečnost účastníků. Cílem je poskytnout robustní nástroj pro hodnocení fairness modelů počítačového vidění a vytvořit realistický standard pro odpovědnou správu dat v AI.

Klíčové body

- FHIBE je lidsky centričný obrazový dataset vytvořený s důrazem na souhlas, soukromí, bezpečnost a férovou odměnu zúčastněných osob.

- Obsahuje široké spektrum demografických, fyzických, environmentálních a technických anotací pro detailní analýzu předsudků v modelech.

- Je určen jako benchmark pro hodnocení fairness u úloh jako pose estimation, person segmentation, face detection/verification a visual question answering.

- Dataset je navržen tak, aby minimalizoval právní i etická rizika spojená s dřívějšími problematickými datasety využívanými bez souhlasu.

- Autoři se snaží nastavit nový standard pro kurátorství dat a ukázat praktický návod, jak budovat důvěryhodné AI systémy.

Podrobnosti

Datasety pro počítačové vidění patří k zásadní infrastruktuře moderní AI, ale historicky byly často sestavovány z otevřených nebo seškrábaných zdrojů bez informovaného souhlasu osob, bez adekvátního zohlednění citlivých atributů a bez kontroly nad tím, jak jsou snímky dále použity. To vedlo k modelům, které trpí systematickými předsudky vůči určitým demografickým skupinám a zároveň představují reputační, právní i bezpečnostní riziko pro firmy, které je nasazují.

FHIBE reaguje na tuto situaci jako účelově navržený „fairness benchmark“ pro lidsky orientované počítačové vidění. Obrazová data byla sbírána s důrazem na informovaný souhlas, transparentní podmínky využití a férovou kompenzaci účastníků. To řeší častý problém dosavadních datasetů, kde lidé nebyli informováni o použití svých fotografií pro trénink a testování AI.

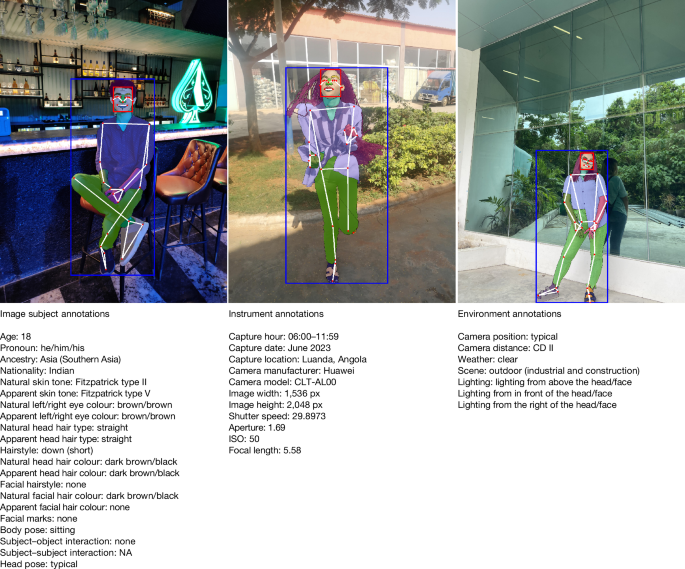

Dataset obsahuje detailní anotace: demografické charakteristiky (např. věk, genderová identita, odstín pleti), fyzické rysy, oblečení, různé prostředí a světelné podmínky, technické parametry snímku, a v některých případech anotace na úrovni pozice, segmentace a konkrétních pixelů. Díky tomu umožňuje nejen měřit agregovanou přesnost, ale také odhalovat jemnější formy biasu – například rozdílný výkon modelu pro různé kombinace atributů, situací a prostředí.

FHIBE je koncipován jako hodnoticí dataset, nikoliv jako nekontrolovaný zdroj pro masivní trénování. Pro vývojáře AI to znamená možnost oddělit trénink na interních nebo komerčních datech od transparentního, eticky kurátorovaného testování fairness. Pro instituce a regulované sektory (banky, pojišťovny, zdravotnictví, veřejná správa) pak dataset nabízí konkrétní nástroj, jak dokládat, že jejich systémy prošly testy spravedlnosti na datech získaných v souladu s moderními etickými standardy.

Proč je to důležité

FHIBE posouvá diskusi o etice a fairness v AI od obecných prohlášení k praktickému, technicky použitelnému nástroji. Z pohledu průmyslu poskytuje realistickou cestu, jak sladit vývoj počítačového vidění s požadavky na ochranu soukromí, souhlas a nediskriminaci, což je klíčové v kontextu přicházejících regulací typu EU AI Act. Zároveň vytváří tlak na opuštění historicky problematických datasetů, které vznikly bez souhlasu a reprezentují riziko pro firmy i akademické instituce.

Pro výzkumníky a vývojáře FHIBE ukazuje, že technicky kvalitní dataset lze navrhnout spolu s etickými principy od začátku, nikoli jako dodatečnou opravu. Pro uživatele a dotčené komunity to znamená vyšší šanci, že systémy pro rozpoznávání obličejů, sledování pohybu, verifikaci identity nebo analýzu scén budou vyhodnocovány na souborech, které lépe odrážejí reálnou rozmanitost a minimalizují systematické selhávání vůči zranitelným skupinám.

Zdroj: 📰 Nature.com